Comunicado de prensa

Para impulsar la próxima ola de centros de datos de IA, NVIDIA anunció su plataforma informática acelerada de próxima generación con arquitectura NVIDIA Hopper, que ofrece un salto de rendimiento de orden de magnitud con respecto a su predecesor.

Nombrada en honor a Grace Hopper, una científica informática pionera de EE. UU., la nueva arquitectura sucede a la arquitectura NVIDIA Ampere, lanzada hace dos años.

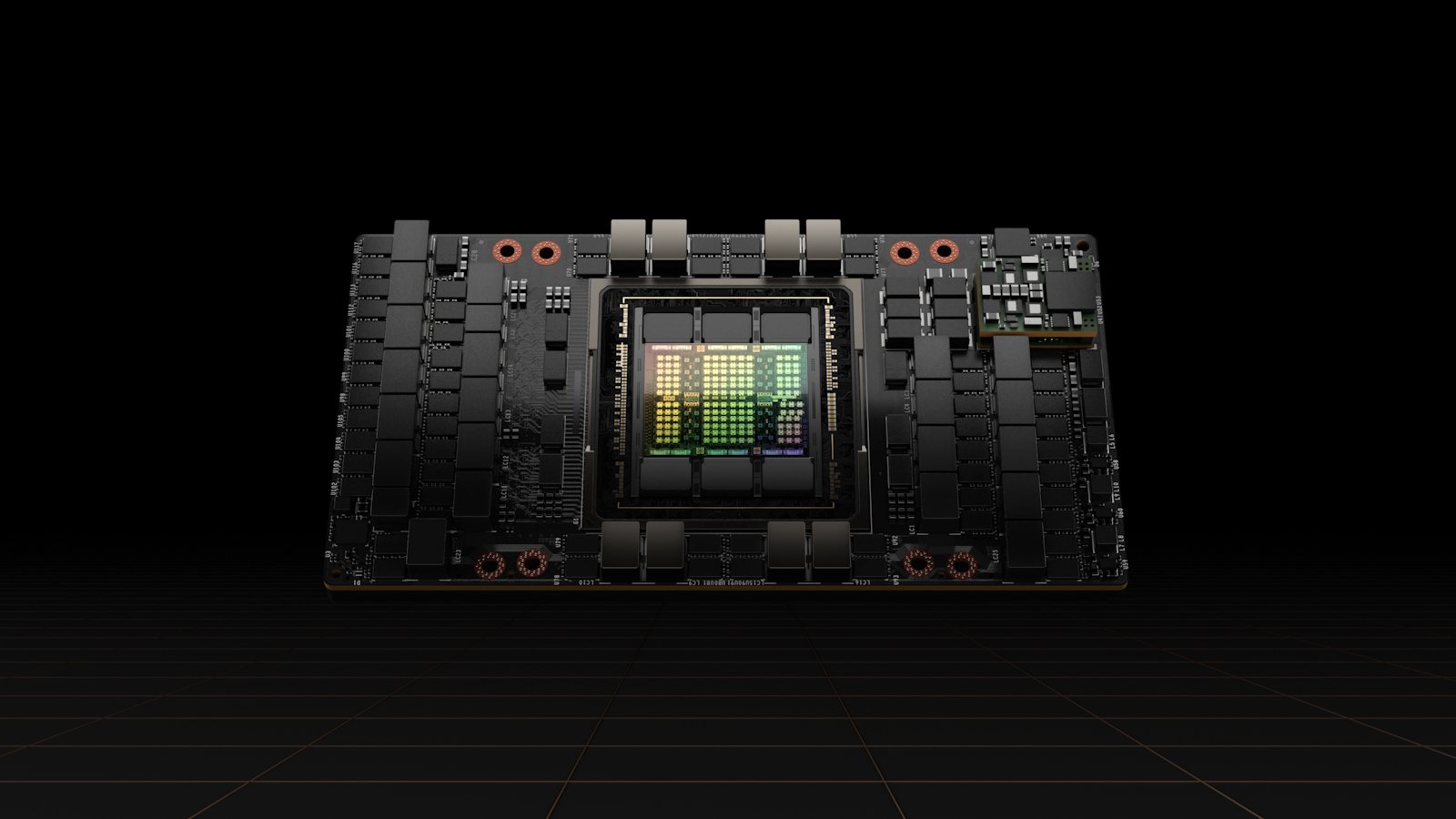

La compañía también anunció su primera GPU basada en Hopper, la NVIDIA H100, con 80 mil millones de transistores. El acelerador más grande y poderoso del mundo, el H100 tiene características innovadoras como un Transformer Engine revolucionario y una interconexión NVIDIA NVLink(R) altamente escalable para avanzar en gigantescos modelos de lenguaje de IA, sistemas de recomendación profundos, genómica y gemelos digitales complejos.

«Los centros de datos se están convirtiendo en fábricas de inteligencia artificial: procesan y refinan montañas de datos para producir inteligencia», dijo Jensen Huang, fundador y director ejecutivo de NVIDIA. «NVIDIA H100 es el motor de la infraestructura de IA del mundo que las empresas utilizan para acelerar sus negocios impulsados por IA».

Avances tecnológicos del GPU H100

La GPU NVIDIA H100 establece un nuevo estándar en la aceleración de IA y HPC a gran escala, y ofrece seis innovaciones revolucionarias:

- El chip más avanzado del mundo: construido con 80 000 millones de transistores mediante un proceso TSMC 4N de vanguardia diseñado para las necesidades informáticas aceleradas de NVIDIA, el H100 presenta importantes avances para acelerar la IA, la HPC, el ancho de banda de la memoria, la interconexión y la comunicación, incluidos casi 5 terabytes por segundo de conectividad externa. H100 es la primera GPU compatible con PCIe Gen5 y la primera en utilizar HBM3, lo que permite 3 TB/s de ancho de banda de memoria. Veinte GPU H100 pueden soportar el equivalente al tráfico de Internet de todo el mundo, lo que hace posible que los clientes ofrezcan sistemas de recomendación avanzados y grandes modelos de lenguaje que ejecutan inferencias en datos en tiempo real.

- Nuevo Transformer Engine: ahora la opción de modelo estándar para el procesamiento del lenguaje natural, el Transformer es uno de los modelos de aprendizaje profundo más importantes jamás inventados. El Transformer Engine del acelerador H100 está diseñado para acelerar estas redes hasta 6 veces en comparación con la generación anterior sin perder precisión.

- GPU segura de instancias múltiples de segunda generación: la tecnología MIG permite dividir una sola GPU en siete instancias más pequeñas y completamente aisladas para manejar diferentes tipos de trabajos. La arquitectura Hopper amplía las capacidades MIG hasta 7 veces con respecto a la generación anterior al ofrecer configuraciones seguras de múltiples inquilinos en entornos de nube en cada instancia de GPU.

- Informática confidencial: H100 es el primer acelerador del mundo con capacidades informáticas confidenciales para proteger los modelos de IA y los datos de los clientes mientras se procesan. Los clientes también pueden aplicar la computación confidencial al aprendizaje federado para industrias sensibles a la privacidad, como servicios financieros y de salud, así como en infraestructuras de nube compartidas.

- NVIDIA NVLink de cuarta generación: para acelerar los modelos de IA más grandes, NVLink se combina con un nuevo conmutador NVLink externo para extender NVLink como una red escalable más allá del servidor, conectando hasta 256 GPU H100 con un ancho de banda 9 veces mayor en comparación con la generación anterior que usa NVIDIA HDR Quantum Infini Band.

- Instrucciones DPX: las nuevas instrucciones DPX aceleran la programación dinámica, utilizada en una amplia gama de algoritmos, incluida la optimización de rutas y la genómica, hasta 40 veces en comparación con las CPU y hasta 7 veces en comparación con las GPU de la generación anterior. Esto incluye el algoritmo Floyd-Warshall para encontrar rutas óptimas para flotas de robots autónomos en entornos de almacén dinámicos, y el algoritmo Smith-Waterman utilizado en la alineación de secuencias para la clasificación y el plegado de proteínas y ADN.

Las innovaciones tecnológicas combinadas de H100 amplían el liderazgo en formación e inferencia de IA de NVIDIA para permitir aplicaciones inmersivas y en tiempo real utilizando modelos de IA a gran escala. El H100 permitirá que los chatbots utilicen el modelo de lenguaje transformador monolítico más poderoso del mundo, Megatron 530B, con un rendimiento hasta 30 veces mayor que la generación anterior, mientras cumple con la latencia de subsegundos requerida para la IA conversacional en tiempo real. H100 también permite a los investigadores y desarrolladores entrenar modelos masivos como Mixture of Experts, con 395 mil millones de parámetros, hasta 9 veces más rápido, reduciendo el tiempo de entrenamiento de semanas a días.

Amplia adopción de NVIDIA H100

NVIDIA H100 se puede implementar en todo tipo de centro de datos, incluidos los locales, la nube, la nube híbrida y el perímetro. Se espera que esté disponible en todo el mundo a finales de este año a través de los principales proveedores de servicios en la nube y fabricantes de computadoras del mundo, así como directamente de NVIDIA.

El sistema DGX de cuarta generación de NVIDIA, DGX H100, cuenta con ocho GPU H100 para ofrecer 32 petaflops de rendimiento de IA con la nueva precisión FP8, proporcionando la escala para cumplir con los requisitos informáticos masivos de modelos de lenguaje grandes, sistemas de recomendación, investigación sanitaria y clima. ciencia.

Cada GPU en los sistemas DGX H100 está conectada por NVLink de cuarta generación, lo que proporciona una conectividad de 900 GB/s, 1,5 veces más que la generación anterior. NVSwitch permite que las ocho GPU H100 se conecten a través de NVLink. Un conmutador NVLink externo puede conectar en red hasta 32 nodos DGX H100 en las supercomputadoras NVIDIA DGX SuperPOD(TM) de próxima generación.

Hopper ha recibido un amplio apoyo de la industria de los principales proveedores de servicios en la nube Alibaba Cloud, Amazon Web Services, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud y Tencent Cloud, que planean ofrecer instancias basadas en H100.

Se espera una amplia gama de servidores con aceleradores H100 de los principales fabricantes de sistemas del mundo, incluidos Atos, BOXX Technologies, Cisco, Dell Technologies, Fujitsu, GIGABYTE, H3C, Hewlett Packard Enterprise, Inspur, Lenovo, Nettrix y Supermicro.

NVIDIA H100 en todas las escalas

H100 vendrá en factores de forma SXM y PCIe para admitir una amplia gama de requisitos de diseño de servidor. También estará disponible un acelerador convergente, emparejando una GPU H100 con NVIDIA ConnectX(R)-7 400Gb/s InfiniBand y Ethernet SmartNIC.

La H100 SXM de NVIDIA estará disponible en placas de servidor HGX(TM) H100 con configuraciones de cuatro y ocho vías para empresas con aplicaciones que escalan a múltiples GPU en un servidor y en varios servidores. Los servidores basados en HGX H100 ofrecen el mayor rendimiento de aplicaciones para el entrenamiento y la inferencia de IA junto con análisis de datos y aplicaciones de HPC.

El H100 PCIe, con NVLink para conectar dos GPU, proporciona más de 7 veces el ancho de banda de PCIe 5.0, lo que brinda un rendimiento excepcional para aplicaciones que se ejecutan en servidores empresariales convencionales. Su factor de forma facilita la integración en la infraestructura del centro de datos existente.

El H100 CNX, un nuevo acelerador convergente, combina un H100 con un ConnectX-7 SmartNIC para brindar un rendimiento innovador para aplicaciones intensivas de E/S, como capacitación de IA multinodo en centros de datos empresariales y procesamiento de señales 5G en el perímetro.

Las GPU basadas en la arquitectura NVIDIA Hopper también se pueden combinar con las CPU NVIDIA Grace con una interconexión NVLink-C2C ultrarrápida para una comunicación 7 veces más rápida entre la CPU y la GPU en comparación con PCIe 5.0. Esta combinación, el Grace Hopper Superchip, es un módulo integrado diseñado para servir aplicaciones de IA y HPC a gran escala.

| Form Factor | H100 SXM | H100 PCIe |

|---|---|---|

| FP64 | 30 teraFLOPS | 24 teraFLOPS |

| FP64 Tensor Core | 60 teraFLOPS | 48 teraFLOPS |

| FP32 | 60 teraFLOPS | 48 teraFLOPS |

| TF32 Tensor Core | 1,000 teraFLOPS* | 500 teraFLOPS | 800 teraFLOPS* | 400 teraFLOPS |

| BFLOAT16 Tensor Core | 2,000 teraFLOPS* | 1,000 teraFLOPS | 1,600 teraFLOPS* | 800 teraFLOPS |

| FP16 Tensor Core | 2,000 teraFLOPS* | 1,000 teraFLOPS | 1,600 teraFLOPS* | 800 teraFLOPS |

| FP8 Tensor Core | 4,000 teraFLOPS* | 2,000 teraFLOPS | 3,200 teraFLOPS* | 1,600 teraFLOPS |

| INT8 Tensor Core | 4,000 TOPS* | 2,000 TOPS | 3,200 TOPS* | 1,600 TOPS |

| GPU memory | 80GB | 80GB |

| GPU memory bandwidth | 3TB/s | 2TB/s |

| Decoders | 7 NVDEC 7 JPEG | 7 NVDEC 7 JPEG |

| Max thermal design power (TDP) | 700W | 350W |

| Multi-Instance GPUs | Up to 7 MIGS @ 10GB each | |

| Form factor | SXM | PCIe |

| Interconnect | NVLink: 900GB/s PCIe Gen5: 128GB/s | NVLINK: 600GB/s PCIe Gen5: 128GB/s |

| Server options | NVIDIA HGX™ H100 Partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs NVIDIA DGX™ H100 with 8 GPUs | Partner and NVIDIA-Certified Systems with 1–8 GPUs |

Soporte de software NVIDIA

La GPU NVIDIA H100 cuenta con el respaldo de potentes herramientas de software que permiten a los desarrolladores y empresas crear y acelerar aplicaciones desde IA hasta HPC. Esto incluye actualizaciones importantes del paquete de software NVIDIA AI para cargas de trabajo como voz, sistemas de recomendación e inferencia a hiperescala.

NVIDIA también lanzó más de 60 actualizaciones de su colección de bibliotecas, herramientas y tecnologías CUDA-X para acelerar el trabajo en computación cuántica e investigación 6G, ciberseguridad, genómica y descubrimiento de fármacos.

Disponibilidad

NVIDIA H100 estará disponible a partir del tercer trimestre.